El tráfico de internet. Los bots en la www

Todos aquellos que tengáis alguna web y estéis pendientes del número de visitas diario del site es posible que os hayáis preguntado alguna vez si ese número se corresponde realmente con personas reales accediendo a vuestro contenido detrás de una pantalla. Muchos ya sabréis la respuesta, pero incluso algunos de estos últimos puede que se lleven una sorpresa.

Hace unos meses se publicó un estudio de la empresa Incapsula mediante el cual establecieron que tan sólo el 49% del tráfico web es generado por usuarios humanos, siendo el 51% restante trafico realizado por bots. ¿Y qué son estos bots? También se conocen como Internet bots, web bots o web robots y consisten en aplicaciones software cuya función es realizar tareas de forma automática, generalmente tareas repetitivas, de manera que se puedan realizar sin intervención humana y de forma mucho más rápida. En el caso particular de la web nos encontramos con los web crawlers o web spiders. Estos bots se dedican a navegar, analizar y recolectar datos de los servidores web que se encuentran. Uno de estos bots, probablemente el más famoso, es Googlebot, el robot de búsqueda utilizado por Google para generar la base de datos de su motor de búsqueda.

El tráfico de internet está plagado de estos programitas, y aunque muchos de ellos realizan funciones beneficiosas e inofensivos muchos otros no son tan inocuos. Incapsula ha calculado que de ese 51% tan sólo el 20% es tráfico generado por los distintos motores de búsqueda y otros bots inofensivos. Esto indica que el 31% del tráfico de nuestra web está siendo utilizado para el lado oscuro. Pero… ¿por quién y para qué?

- El 5% del tráfico es generado por herramientas de hacking. Aunque en el estudio no hacen ninguna distinción en este apartado, me gustaría puntualizar que el hacking en sí no es la delincuencia informática que nos dicen habitualmente. El hacking consiste en la búsqueda permanente del conocimiento de los sistemas informáticos, de manera que puedan ser mejorados, solventando sus problemas y eliminando sus vulnerabilidades. Por supuesto que este conocimiento puede aplicarse al lado oscuro, y ahí sí encontramos a los delincuentes informáticos, a los que se les denomina crackers (del inglés crack: romper). Aunque entiendo que este apartado debe englobar a los dos grupos, seguramente sí que será mayoritaria la proporción de crackers frente a hackers.

- Otro 5% del tráfico es generado por scrapers, programas encargados de extraer datos de una web, como puede ser información de un negocio, productos, precios, extraer información personal, escanear blogs, direcciones de email… Es muy habitual encontrarse con réplicas de blogs (sin consentimiento de sus autores) en webs repletas de publicidad con el propósito de obtener beneficio económico con un mínimo esfuerzo. Otra práctica muy habitual es la de recopilar direcciones de correo electrónico para posteriormente incluirlas en las odiadas listas de spam.

- Un 2% del tráfico es generado por los denominados comment spammers, que son esos programas que dejan comentarios sin mucho sentido (aunque van mejorando peligrosamente) con el propósito de añadir enlaces (para mejorar el SEO) a sus propios contenidos, blogs, webs comerciales, etc. o simplemente molestar y ralentizar la web.

- Por último, un 19% del tráfico es generado por otros tipos de software espía. Su función abarca desde recolectar datos de los sitios web, robo de datos de marketing y estrategias competitivas, etc.

Vemos, por lo tanto, que aunque no es apreciable a simple vista, internet es una jungla en la que continuamente se disputa la información y su acceso. Debemos, por tanto tener cuidado y monitorizar lo que ocurre dentro de nuestra web. Para ello existen diferentes alternativas en función de la tecnología que estemos usando, por lo que es necesario informarse bien.

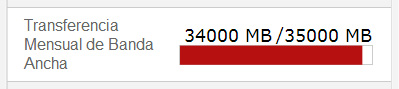

También me gustaría mencionar que, aunque no es parte de dicho estudio, y no se trata de tráfico «atacante» como tal, muchas veces nos podemos encontrar con que alguien, desde otra web, está robándonos parte de nuestra Transferencia Mensual de Banda Ancha contratada. A no ser que dispongamos de un servidor y alojamiento propios debemos contratar un límite de transferencia mensual de datos, ya que el ancho de banda disponible es limitado incluso para nuestro proveedor de hosting. Obviamente, que alguien consuma nuestra transferencia mensual contratada es un gran perjuicio para nosotros, ya que esta cantidad es limitada y una vez alcanzado dicho límite deberemos facturar el resto del tráfico pagando una cantidad extra o nuestro proveedor cortará la conexión a nuestro servidor web.

Una forma de robar nuestro ancho de banda es mediante la técnica conocida como hotlinking o inline linking que consiste en poner en una web imágenes que no están en dicha web mediante un enlace a su fuente original. Como la World Wide Web está diseñada para permitirlo las imágenes se mostrarían, de forma totalmente transparente al usuario, como si perteneciesen a esa web. Desde el punto de vista del análisis del tráfico esto significa que cuando un usuario visualice la web que realiza hotlinking también generará tráfico a nuestra web para descargarse la imagen, lo que irá consumiendo nuestra transferencia mensual. Y, por supuesto, sin obtener ningún beneficio a cambio. Imaginaos en el caso de imágenes muy grandes y/o enlaces en páginas con gran afluencia de usuarios.

Entérate de más –> Incapsula

muy interesante el post me aclaro bastantes dudas hago presencia desde http://moveer.url.ph saludos